3과목 데이터 분석

5장 정형 데이터 마이닝

1절 데이터마이닝 개요

분석 목적에 따른 작업 유형과 기법

추진 단계

- 목적 설명

- 데이터 준비

- 가공

- 기법 적용

- 검증

데이터 분할

성과분석

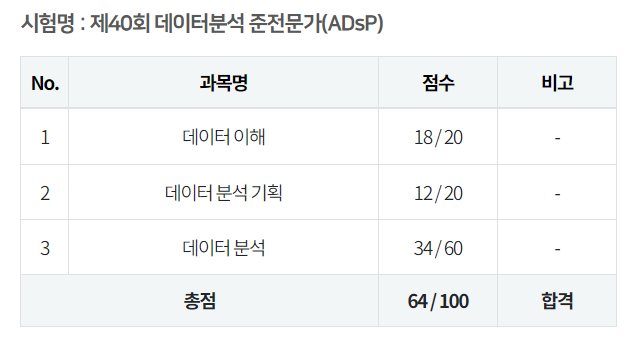

| | 조건 O (Positive) | 조건 X (Negative) |

|---|

| 예측 O (Positive) | TP (맞춤) | FP |

| 예측 X (Negative) | FN | TN (맞춤) |

- 정분류율 : TP+TN / 전체

- 오분류율 : FP+FN / 전체

- 특이도 : TN / FP+TN (거짓 중에 맞출 확률)

- 민감도 : TP / TP + FN (참 중에 맞을 확률)

- 정확도 : TP / TP + FP (참으로 예측한 것이 맞을 확률)

- 재현율 : TP / TP + FN

- F1 Score = 2*정확도*재현율 / (정확도+재현율)

ROCP Curve

- 가로축을 FPR(1-특이도), 세로축을 TPR(민감도) 값으로 두고 시각화

- 곡선 아래 면적이 클수록 성능이 좋은 모형

이익도표

분류모형의 성능을 평가하기 위한 척도, 구간별 반응검출율, 반응률, 향상도 고려

- 기본 향상도 = 구매자 비율

- 반응검출율 = 해당 등급 구매자 / 전체 구매자

- 반응률 = 해당 등급 구매자 비율

- 향상도 = 반응률 / 기본 향상도, 좋은 모델일 경우 빠른 속도로 감소

2절 분류분석

분류분석과 예측분석의 정의

- 분류분석 : 데이터의 그룹 예측, 범주형 속성 값

- 예측분석 : 시간에 따른 값 예측, 연속형 속성 값

로지스틱 회귀분석

- 새로운 설명변수가 주어질 때 반응변수의 각 범주에 속할 확률을 추정하여 분류

- 사후확률 : 모형의 적합을 통해 추정된 확률

- 종속변수 = 0, 1

- 계수 추정법 : 최대우도추정법

- 모형 검정 = 카이제곱 검정

오즈

- 오즈 : 성공할 확률이 실패할 확률의 몇 배인지 나타내는 확률

- 오즈비 : 오즈의 비율

의사결정나무

분류함수를 의사결정 규칙으로 이루어진 나무 모양으로 그리는 방법

활용

- 세분화

- 분류

- 예측

- 차원 축소 및 변수 선택

- 범주 병합 및 연속형 변수 이산화

특징

장점

- 설명 용이

- 단순 계산

- 빠른 생성

- 수치형 변수와 범주형 변수 모두 사용 가능

- 높은 정확도

단점

- 과대적합 가능성

- 경계선 부근 자료값의 큰 오차

- 중요도 판단에 어려움

과정

성장 : 각 마디마다 최적의 분리규칙을 찾아 나무 성장, 적절한 정지규칙 만족 시 중단

가지치기 : 불필요한 가지 제거

타당성 평가 : 이익도표, 위험도표, 시험자료를 이용하여 평가

해석 및 예측 : 구축된 나무모형 해석, 예측모형 설정 후 적용

의사결정나무 알고리즘

- CART : 변수가 범주형인 경우 지니지수, 연속형인 경우 이진분리 사용

- C4.5와 C5.0 : 다지분리 가능, 엔트로피지수 사용

- CHAID : 범주형 변수, 카이제곱 통계량 사용

3절 앙상블 분석

주어진 자료로부터 여러 개의 예측모형을 만든 후 예측모형을 조합하여 하나의 최종 예측 모형을 만드는 방법

종류

배깅 : 여러개의 부트스트랩 자료를 생성하고 각 부트스르랩 자료에 예측모델을 만든 후 결합하여 최종 예측 모델 생성

부트스트랩 : 주어진 자료에서 동일한 크기의 표본을 랜덤복원추출

보팅 : 여러 개의 모형으로부터 산출된 결과를 다수결에 의해서 최종 결과로 선정하는 것

가지치기를 하지 않고 최대로 성장한 의사결정나무 활용

훈련자료의 모집단의 분포를 모르기 때문에 실제 평균예측모형 산출 불가

=> 훈련자료를 모집단으로 생각하고 평균예측모형을 구하여 분산을 줄이고 예측력 향상

부스팅 : 예측력이 약한 모형을 결합하여 강한 예측 모형을 만드는 방법

- Adaboost : 분류기에 각각 가중치를 설정하여 결합(가중치합 1)

- 예측오차 향상

랜덤 포레스트 : 더 많은 무작위성을 주어 약한 삭습기를 생성한 후 선형으로 결합하여 최종 학습기 생성

- 변수제거 없이 실행되므로 정확한 측면에서 좋은 성과

- 어려운 해석, 높은 예측력

4절 인공신경망 분석

인공 신경망 학습

단일 뉴런 학습(단층 퍼셉트론)

선형 결합기와 하드 리미터로 구성

신경망 모형 구축 시 고려사항

5절 군집분석

각 객체의 유사성을 측정하여 유사성이 높은 대상 집단을 분류하고, 군집에 속한 객체들의 유사성과 다른 군집에 속한 객체간의 상이성을 규명

거리

연속형 변수

- 유클리디안 거리

- 표준화 거리 : 표준편차로 척도 변환한 후 유클리디안 거리 계산

- 마할라노비스 거리 : 통계적 개념이 포함된 거리

- 체비셰프 거리

- 맨하탄 거리

- 캔버라 거리

- 민코우스키 거리 : 맨하탄 거리와 유클리디안 거리를 한번에 표현한 공식

범주형 변수

- 자카드 거리

- 자카드 계수

- 코사인 거리 : 문서를 유사도를 기준으로 분류할 때 사용

- 코사인 유사도

계층적 군집분석

n개의 군집으로 시작해 군집 개수를 줄역 나가는 방식

비계층적 군집분석

혼합 분포 군집

자기조직화지도SOM

6절 연관분석

조건과 반응의 형태로 거래 또는 사건 간의 규칙 발견

측도

- 지지도 P(A ∩ B) : 항목 A와 항목 B를 동시에 포함하는 거래

- 신뢰도 P(A ∩ B) / P(A) = P(B | A) : 항목 A를 포함한 거래 중에서 항목 A와 항목 B가 같이 포함될 확률

- 향상도 P(B | A) / P(B) : 품목 B의 구매확률에 비해 A가 구매됐을 때 품목 B의 구매확률 증가비

절차

- 최소 지지도 선정

- 최소 지지도를 넘는 품목 분류

- 2가지 품목 집합 생성

- 반복 수행

특징

장점

- 탐색적 기법

- 비목적성 분석기법

- 사용이 편한 데이터 형태

- 계산이 용이

단점

- 품목 증가에 따른 급격한 계산 수 증가

- 너무 세분화 시 무의미해질 수 있음.

- 거래량이 적은 품목의 비중